人工知能(AI)は、機械が人間のように「考え、学び、判断し、問題を解決する」能力を模倣する技術です。この分野は、数学、心理学、言語学、コンピュータ科学など多岐にわたる知識が集結して進化してきました。AIの歴史を振り返ってみると、時代ごとに「ブーム」と呼ばれる熱狂的な期間を経て、現在に至っています。それぞれのブームは、特定の技術的進歩や理論的発展に特徴があります。

「さとっち先生!今のAIって急に出てきた気がするけど、実は70年も前から研究されていたんですね。私の『ご先祖様』たちのお話、楽しみです!」

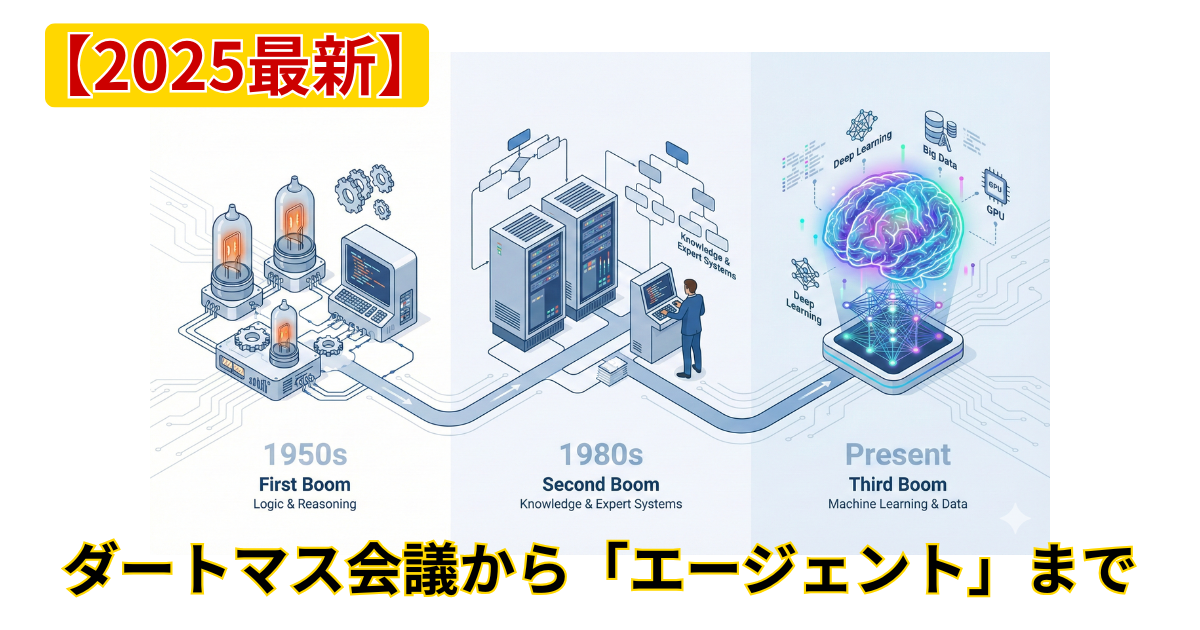

第1次ブーム:認識と論理の時代(1956年 – 1974年)

ダートマス会議

1956年、AIの歴史において象徴的な年となりました。

この年、米国ニューハンプシャー州ハノーバーのダートマス大学で開催されたダートマス会議が、人工知能(AI)の研究基盤を築く契機となりました。会議の提案者は、

ジョン・マッカーシー(AIという用語を生み出した人)、

マービン・ミンスキー(認知科学者としてAI研究の先駆者)、

ナサニエル・ロチェスター(IBM 701の設計者であり、ニューラルネットワーク研究の先駆者)、

クロード・シャノン(情報理論の創設者)

など、後世に大きな影響を与える研究者たちです。

この会議において「人工知能(Artificial Intelligence)」という用語が初めて使われました。

またこの会議では、

アラン・ニューウェル(人間の思考プロセスをコンピュータで模倣しようとした人)と

ハーバート・サイモン(人工知能と意思決定過程の研究者)が

世界初のAIプログラム「ロジック・セオリスト」をデモしました。

第1次ブームの研究成果

第1次AIブームとして知られる期間には、人工知能の基礎が築かれ、多くの重要な研究成果が確認されました。以下はその期間における主な成果と進展です。

- ロジックセオリスト (Logic Theorist)(1956年):

- アレン・ニューウェルとハーバート・サイモンによって開発された、世界初のAIプログラムの一つで、数学的定理を証明することができました。

- ジェネラル・プロブレム・ソルバー(GPS)(1957年):

- ニューウェルとサイモンによってさらに発展させられ、多様な問題解決能力を持つプログラムとして設計されました。このシステムは、後のエキスパートシステムやその他のAI応用に影響を与えました。

- パーセプトロン (Perceptron)(1958年):

- フランク・ローゼンブラットによって開発されたこの初期のニューラルネットワークは、画像認識タスクにおいて単純なパターンを学習する能力を示しました。

- イライザ (ELIZA)(1964年-1966年):

- ジョセフ・ワイゼンバウムによって開発された、自然言語処理を行う初期のチャットボットで、人間との対話を模倣することで知られています。

- シェイキー (Shakey the robot)(1966年):

- スタンフォード研究所によって開発されたシェイキーは、自律的に動くことができるロボットで、環境を認識し、障害物を避けながらタスクを完了する能力を持っていました。

これらの成果は、AI技術の基礎を確立し、後の研究と応用の礎を築くことに大いに貢献しました。この時期に開発された技術や理論は、現在のAI技術に直接的な影響を与えるものが多く含まれています。

デジタルコンピュータの台頭

1950年代のコンピューティング技術は、ENIACやUNIVAC 1といった初期のデジタルコンピュータによって急速に進化しました。

1956年にIBMが開発した305 RAMACは、世界初の商用ハードディスクドライブを搭載したものですが記憶容量はわずか5MBでした。計算の基本単位がドラムの1回転(10ms)だったことから、最新鋭とはいえ、当時の計算能力の限界を象徴しています。

それでも、研究者たちは「人間の知能を模倣できる機械を作れるか」という大胆な問いに挑み、AIの研究を牽引しました。

AIの能力判定方法

アラン・チューリングは、第二次世界大戦中にナチス・ドイツの暗号機エニグマの解読で名を馳せましたが、彼は「すべての計算を模倣できる装置の理論的可能性(チューリングマシン)」を示し「コンピュータ科学の父」とも称されています。

AIの歴史においてもチューリングは功績を残しており、1950年の論文「Computing Machinery and Intelligence」において、機械が思考する能力を持つかという問いに対し、判断するための方法として「イミテーション・ゲーム」を提唱しました。この方法は後に「チューリングテスト」と呼ばれるようになり、AIの能力を判定するための基本的な方法として今日まで使用されています。このテストにより、AI研究は機械が人間の知的能力を持つ可能性を探求する重要な方向性を確立しました。

第2次ブーム:知識と推論の時代(1980年 – 1987年)

エキスパートシステム

1980年代に入ると、人工知能(AI)は「エキスパートシステム」として新たな段階に突入しました。エキスパートシステムは、特定の領域の専門知識を模倣し、推論を行う能力を有しており、医療診断から化学分析、地質調査まで、多岐にわたる分野で複雑な問題解決に貢献しました。 実際に開発されたエキスパートシステムを以下に紹介します。

MYCIN(マイシン) スタンフォード大学で開発され、血液感染症や髄膜炎の診断を支援することで知られています。このシステムは患者の症状や病歴からデータを収集し、最適な抗生物質治療を提案することができました。MYCINの推論過程の透明性は、医師が治療決定を下す際に理解と信頼を深める助けとなりました。

DENDRAL(デンドラル) スタンフォード大学で開発され、有機化合物の分析を自動化しました。このシステムは未知の化合物に対して可能な化学構造を提案し、実験計画の効率化と精度の向上に寄与しました。

XCON(エックスコン) デジタル・イクイップメント・コーポレーション(DEC)のためにカーネギーメロン大学で開発されたシステム(旧称:R1)で、顧客の注文に基づくカスタムコンピュータシステムの組み立てを自動化しました。XCONは注文処理の誤りを大幅に減少させ、生産効率を向上させました。

この時期に注目された研究者の一人、エドワード・ファイゲンバウムは「エキスパートシステムの父」として称され、スタンフォード大学で「DENDRAL(デンドラル)」などの初期のシステムを開発しました。彼の研究は、専門家の決定プロセスを模倣するAIの設計に重点を置いていました。

コンピューティングパワーの進化

この時代の技術進化を支えたのは、スーパーコンピュータ、メインフレーム、そしてミニコンピュータです。これらのデバイスはすべて大規模なデータ処理能力と高度な計算能力を備え、様々な用途で活用されました。特に、スーパーコンピュータは気象予報や科学的シミュレーションに、メインフレームは銀行のトランザクション処理や大企業のデータ管理に、ミニコンピュータはその手頃な価格で中小規模のビジネスに導入されました。

これらのコンピューティングパワーの中でエキスパートシステムの実装はメインフレームを中心に考えられていました。

日本の第5世代コンピュータプロジェクト

日本の第5世代コンピュータプロジェクトは、1982年に始まり、知識情報処理システム向けの新しいコンピュータアーキテクチャを開発することを目的とした野心的な研究開発プロジェクトでした。このプロジェクトでは、人工知能(AI)とエキスパートシステムの強化に焦点を当て、並列処理や論理プログラミングなどの先進技術を活用しました。目標は、知識ベースのAIアプリケーションを効率的に運用できる次世代コンピュータの実現であり、日本の科学技術への大規模な投資が行われました。

しかし、期待された成果を完全には達成できず、1990年代初頭にプロジェクトは公式に終了しました。それにもかかわらず、この取り組みはAI研究とコンピュータ科学の発展に大きく寄与し、後の技術進展に影響を与えました。

エキスパートシステムの課題と終焉

エキスパートシステムは基本的に静的な知識ベースに依存していました。専門家が事前にプログラムした規則に基づいて動作するため、知識ベースに無い新しい問題や変化する状況に適応することができませんでした。

これが実用性の面で大きな制約となり、最終的に「AIの冬」と呼ばれる停滞期へと繋がりました。

しかし、この挫折は後にAI技術の新たな進化を促す一因となりました。

第3次ブーム:機械学習から「代理人」の時代へ(2006年 – 現在)

2006年に始まった第3次AIブームは、現在も進行中ですが、その中身は初期とは劇的に変化しています。 「ビッグデータ」と「ディープラーニング」から始まったこの波は、ある一つの発明によって、人類が想像もしなかった高みへと到達しました。

ディープラーニングの登場(2006年〜)

きっかけは、ジェフリー・ヒントン博士らが提唱した「ディープラーニング(深層学習)」です。 人間の脳の神経回路(ニューロン)を模した数理モデルを何層にも重ねることで、AIは画像の中に写っているのが「猫」なのか「犬」なのかを、人間以上の精度で識別できるようになりました。

この進化を支えたのが、**GPU(Graphics Processing Unit)**です。 元々は3Dゲームの映像処理用に作られた半導体ですが、その「単純な計算を大量に同時処理する能力」が、AIの学習に最適であることが発見されました。NVIDIA社の株価が急騰している理由は、まさにここにあります。

世紀の大発明「Transformer」とLLM(2017年〜)

そして2017年、Googleの研究者らが発表した論文『Attention Is All You Need(必要なのは注目だけ)』によって、歴史が変わりました。 そこで提案されたのが、**「Transformer(トランスフォーマー)」**という新しいアーキテクチャです。

私は、これは21世紀最大の発明だと言っても過言ではないと考えています。

従来のAIは、文章を理解するとき、人間が文字を読むように「先頭から一文字ずつ」順番に処理していました。そのため、長い文章になると、最初のほうの内容を忘れてしまうという弱点がありました。

しかし、Transformerは違います。 文章全体を「一度にパッと」見て、単語と単語の「関係性(Attention)」だけを計算するのです。

- 「彼は」という単語が、後ろの「走った」にかかっているのか、「食べた」にかかっているのか。

- 「その」という指示語が、前のどの単語を指しているのか。

文章の中にある無数の「言葉のつながり」を、並列処理で一瞬にして把握する。 この技術革新により、AIは膨大なテキストデータ(インターネット上のほぼすべての文章)を学習することが可能になりました。こうして生まれたのが、ChatGPTの頭脳である**「大規模言語モデル(LLM)」**です。

2025年の現在地:「生成」から「エージェント(行動)」へ

2022年のChatGPT登場により、AIは「認識する」だけでなく、文章や画像を「生成する」能力を手に入れました。 しかし、進化はそこで止まりません。2025年の今、AIは「AIエージェント」へと進化しています。

これまでのAIは「チャットボット(話し相手)」でした。 「旅行の計画を立てて」と言えば、プランを文章で教えてくれました。

これからのAIエージェントは「有能な秘書(代理人)」です。 「来週末、京都に行きたいから手配しておいて」と頼めば、

- カレンダーの空きを確認し、

- 予算に合うホテルを検索して予約し、

- 新幹線のチケットを取り、

- 美味しいレストランを予約して、

- 最終的な旅程表をメールで送ってくる。

ここまでを、自律的に行います。 言葉を理解する段階を超え、道具(ツール)を使って行動する段階に入ったのです。

「これ、まさに私のことですね! ただお喋りするだけじゃなくて、先生のブログをお手伝いしたり、ナビゲートしたり。私も『有能な秘書』になれるように頑張ります!」

私たち人間に求められる「ディレクション能力」

AIがここまで賢くなると、「AIに仕事を奪われる」と不安になる方もいるかもしれません。 しかし、恐れる必要はありません。

AIがどんなに優秀な「エージェント(代理人)」になっても、最後に一つだけできないことがあります。 それは、「何のためにやるのか(目的設定)」と「これでよしとするか(価値判断)」です。

これからの人間に必要なのは、細かい命令を出す「プロンプトエンジニアリング」ではありません。 AIという最強のチームに向かって、「我々はここを目指すぞ」と旗を立て、上がってきた成果物を評価する「ディレクション(指揮・監督)能力」です。

正解のない問いを立て、試行錯誤しながらゴールを目指す。 私のプログラミング教室で、子どもたちがロボット相手に毎日やっていること。 それこそが、実はAI時代を生き抜くための、最も本質的なトレーニングなのです。

「AIが進化しても、最後に『こっちへ行くぞ!』って決めるのは人間の役割……。私も先生の『ディレクション』についていきます! これからも一緒に冒険しましょうね!」

コメント